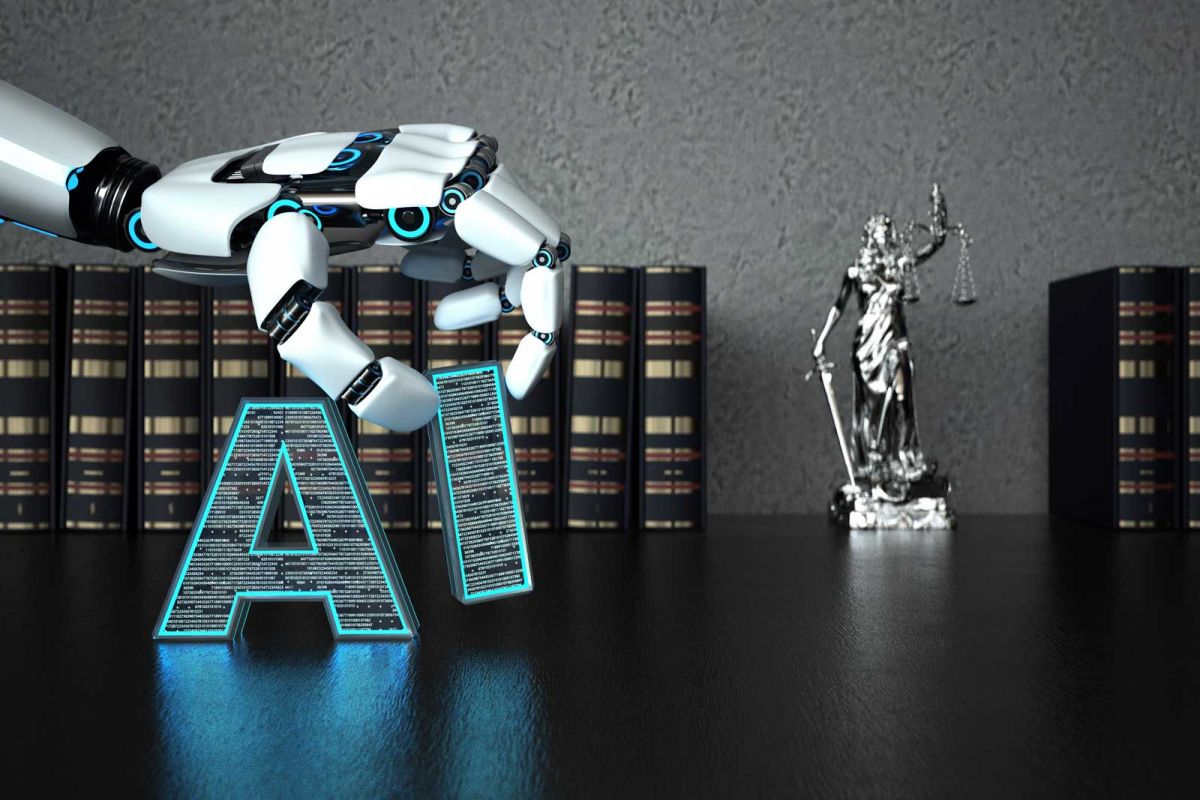

Sztuczna inteligencja, sztuczna odpowiedzialność?

Artificial Intelligence (AI) święta nie jest. Oprócz tego, że robi wiele dobrego dla ludzkości, zdarza się jej też nieźle nabałaganić. Do tego rozwija się w zastraszającym tempie i podbija coraz większe obszary działalności, które do tej pory stanowiły wyłącznie domenę ludzką. Pojawia się więc całkiem rozsądne pytanie: kto będzie ponosił odpowiedzialność za wyrządzone przez AI szkody?

Znalezienie konkretnej odpowiedzi oraz uregulowanie jej w przepisach prawnych stanowi teraz najpoważniejsze wyzwanie, stojące przed branżami zaangażowanymi w rozwój AI. Jeżeli nie chcą one bowiem doprowadzić do powstania anarchii i chaosu, to muszą znać zakres odpowiedzialności za stworzoną i kierowaną swoimi rękami technologię oraz być gotowe ją ponosić. Obecnie nadal przecież nie jest jasne, kto i w jakich okolicznościach powinien ponosić odpowiedzialność za wady systemu informatycznego. Czy powinny być to firmy, które wprowadzają na rynek produkty oparte na bazie AI, czy też raczej tworzący te systemy informatycy? W jaki sposób można zminimalizować ryzyko powstania szkody? Sztuczna inteligencja wymaga od prawodawców szczegółowego zdefiniowania zagadnień prywatności, bezpieczeństwa, odpowiedzialności i etyki w kontekście „cyfrowej tożsamości”.

Poprawnemu i efektownemu przebiegowi procesu legalizacji przepisów w tej materii z pewnością nie sprzyja zawrotne tempo rozwoju AI, które może skutkować dezaktualizacją ustalonych definicji, zanim te będą miały w ogóle szansę wejść w życie. Takie ryzyko nie może jednak doprowadzić do zastoju prac. A te trwają aktualnie na szczeblu europejskim, a wynalezione rozwiązania będą obowiązywać na terenie państw UE. Warto zauważyć, że pierwsze propozycje dotyczące takich regulacji Komisja Europejska ujawniła już w 2021 roku. W ówczesnej „ofercie” KE nie znalazły się niestety żadne nowe czy innowacyjne przepisy. Zarządzono jedynie, aby zasady odpowiedzialności wywodzono w poszczególnych przypadkach indywidualnie, bazując na regulacjach Kodeksu cywilnego oraz prawnych relacjach producenta i konsumenta.

Efektem stosowania tych wytycznych było wyróżnienie w kontekście odpowiedzialności dwóch kluczowych podmiotów: operatora oraz producenta. Wśród wariantów odpowiedzialności przewidziano dwa. Jeden jest oparty na zasadzie ryzyka, a drugi na zasadzie winy. W pierwszym przypadku istotna jest znaczna możliwość wyrządzenia przez system AI działający autonomicznie losowo występujących szkód. To, że operujący ślepo system będzie powodował szkody, jest w zasadzie pewne i istniejące w takim przypadku ryzyko trzeba z pokorą przyjąć do wiadomości. W drugim modelu następuje konfrontacja z systemami innymi niż te wysokiego ryzyka. Odpowiedzialność na zasadzie winy agreguje szkody spowodowane przez fizyczne lub wirtualne działanie AI, a także urządzenia sterowane tym systemem bądź na skutek procesu, który został na tym systemie oparty. Naturalnie, oba warianty przewidują „tradycyjne” wyłączenia odpowiedzialności, np. na skutek działania siły wyższej.

A czy możemy zabezpieczyć się przed potencjalnymi szkodami spowodowanymi przez AI? Owszem, jest na to kilka sposobów. UE lobbuje wprowadzenie ubezpieczeń na rzecz użytkowników AI. W planach jest także utworzenie funduszu na rzecz ofiar. Z dokładnymi zasadami funkcjonowania tych konstrukcji będziemy mogli się zapoznać, gdy prace nad uregulowaniem materii odpowiedzialności za AI dobiegną końca.

Przeczytaj też:

Poetycka sztuczna inteligencja

Wojny dronów

Zakochana sztuczna inteligencja

Komunistyczna sztuczna inteligencja

Ogłupianie sztucznej inteligencji

Cyfrowa puszka Pandory

Sztuczna inteligencja (AI) kłamie, czy nie potrafi rozumnie przetwarzać informacji?!

Czy technologia zniszczy instytucję rodziny?

Co czują algorytmy?

W odporności na kłamstwo siła

Redaktor naczelny: Paweł Łepkowski | Edytor: Marta Narocka-Harasz

Kontakt: Ten adres pocztowy jest chroniony przed spamowaniem. Aby go zobaczyć, konieczne jest włączenie w przeglądarce obsługi JavaScript.

Stale współpracują: Zofia Brzezińska, Robert Cheda, Jacek Cieślak, Zuzanna Dąbrowska, Gaja Hajdarowicz, Grzegorz Hajdarowicz, Mariusz Janik, Krzysztof Kowalski, Hubert Kozieł, Marek Kutarba, Jakub „Gessler” Nowak, Tomasz Nowak, Joanna Matusik, Justyna Olszewska, Marcin Piasecki, Paweł Rochowicz.